毕业设计:基于深度学习的运动目标识别追踪系统 目标检测 人工智能

毕业设计:基于深度学习的运动目标识别追踪系统利用深度学习模型对视频帧进行特征提取,然后通过目标检测算法识别出运动目标,并利用目标追踪算法对目标进行持续追踪。详细介绍了系统的整体架构、关键技术以及实现方法,并通过实验验证了系统的有效性和鲁棒性。为计算机毕业设计提供了一个创新的方向,结合了深度学习和计算机视觉技术,为毕业生提供了一个有意义的研究课题。对于计算机专业、软件工程专业、人工智能专业、大数据专

目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于深度学习的运动目标识别追踪系统

设计思路

一、课题背景与意义

随着计算机视觉和深度学习技术的快速发展,运动目标识别与追踪成为了研究的热点。运动目标识别追踪系统能够自动识别和追踪视频中的运动物体,对于智能监控、人机交互、机器人导航等领域具有重要的应用价值。然而,由于动态场景变化、光照变化、遮挡等问题,运动目标识别与追踪仍然面临许多挑战。因此,研究基于深度学习的运动目标识别追踪系统具有重要的理论和实际意义。

二、算法理论原理

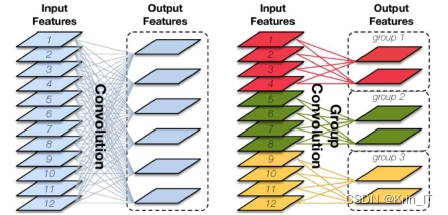

2.1 卷积神经网络

图像增强方法在雾霾天气和夜间图像中有不同的应用。在雾霾天气下,去雾算法的目标是通过滤除雾霾来改善图像质量,突出感兴趣的特征并抑制不需要的特征。大气光照模型是去雾算法的基础,它描述了白天天气下图像成像的原理,其中图像包括反射光和大气散射光的总和。在雾天环境下,图像变得模糊是由于大气散射的影响,这为去雾算法提供了研究的切入点。而对于夜间图像,常见的问题是光照不均匀,主要是由于路灯过亮造成的。因此,在夜间图像增强中,需要实现亮度均衡的特点,以改善图像的视觉效果。

夜间成像的特点在于亮度分布不均匀,而针对夜间图像增强的研究中,可以借鉴何恺明博士对暗通道的分析。在雾天图像中,可以找到最接近真实亮度信息的点,如果整幅图像都存在雾霾情况,那么大气光照值的预测就会偏大,并且处理过程会使图像越来越黑。基于这个观察,夜间成像增强实验可以将图像中最亮的点视为光源本身,而不考虑真实的大气光照强度。因此,在夜间成像增强中,关键是找到亮度最高的暗通道,并根据该部分亮度对整体图像进行高亮部分的弱化,同时对非高亮部分进行一定程度的增强。这样可以实现夜间图像的增强效果,改善图像的视觉质量。

2.2 YOLOv5算法

YOLOv5是一种广泛应用于目标检测和跟踪任务的算法。它是YOLO(You Only Look Once)系列算法的最新版本,相较于之前的版本,YOLOv5采用了一些改进和优化,提高了检测性能和速度。在运动目标检测方面,YOLOv5能够快速而准确地检测图像或视频中的运动目标。它通过将输入图像划分为网格,并在每个网格中预测边界框和类别,从而实现目标检测。与传统的两阶段目标检测算法相比,YOLOv5采用了单阶段的检测方法,使得检测速度更快,并且在保持准确性的同时能够处理大规模的目标。

YOLOv5的算法原理主要由以下几个组成部分构成:

- Backbone网络:YOLOv5使用了一种轻量级的神经网络作为其主干网络,用于提取输入图像的特征。这个主干网络可以是经过预训练的卷积神经网络,如MobileNetV3或EfficientNet,也可以是自定义的网络结构。

- Neck网络:在主干网络之后,YOLOv5引入了一种称为Neck的模块,用于进一步提取特征并进行多尺度特征融合。这有助于提高目标检测的准确性和鲁棒性。

- Head网络:在Neck网络之后,YOLOv5使用了一个称为Head的模块,用于预测目标的边界框和类别。Head网络包括一系列卷积和线性层,用于生成目标检测的输出。

- 损失函数:YOLOv5使用一种称为YOLO Loss的损失函数来衡量预测框和真实框之间的差异,并用于训练网络。YOLO Loss结合了边界框坐标的回归损失和分类损失,以提高目标检测的准确性。

2.3 k-means 算法

在某些跟踪算法中,需要在视频序列的第一帧中初始化目标的位置和大小。k-means算法可以通过对第一帧中的像素进行聚类,将图像分割为不同的颜色区域。然后可以根据聚类结果选择其中一个区域作为目标的初始位置,或者通过计算聚类中心来确定目标的位置和大小。可以使用k-means算法对目标的颜色特征进行聚类,从而在视频序列中跟踪具有相似颜色的目标。通过不断更新聚类结果,可以实现目标的持续跟踪,并对目标的位置和大小进行估计。

k-means算法是一种常用的聚类算法,其原理和组成如下:k-means算法通过将数据集划分为k个不同的簇,使得每个数据点都属于距离最近的簇的中心。算法首先随机选择k个初始聚类中心,然后迭代地进行两个步骤:第一步是将每个数据点分配到距离其最近的聚类中心所属的簇;第二步是更新每个簇的聚类中心,即将每个簇内所有数据点的均值作为新的聚类中心。这两个步骤交替进行,直到聚类中心不再改变或达到预定的迭代次数。k-means算法的目标是最小化数据点与其所属簇聚类中心之间的距离平方和,即最小化簇内的方差。通过迭代优化,k-means算法能够将数据点划分为不同的簇,形成紧凑且相似的簇群。

三、检测的实现

3.1 数据集

在构建基于深度学习的运动目标识别追踪系统时,数据集的质量和数量至关重要。由于公开可用的运动目标数据集有限,且难以满足实际应用的需求,我决定自行制作一个运动目标数据集。我首先选择了多种不同的场景和拍摄设备,拍摄了大量的视频数据。然后,我利用标注工具对视频帧中的运动目标进行手动标注,生成了包含运动目标边界框和类别信息的标注数据。最后,我对原始视频数据进行了预处理和增强操作,以增加数据集的多样性和鲁棒性。通过这一系列的步骤,我成功地制作了一个高质量的运动目标数据集,为系统的训练提供了有力支持。

数据扩充是提升深度学习模型性能的有效手段之一。对于运动目标识别追踪系统而言,数据扩充可以帮助模型更好地泛化到不同的场景和变化。一种常见的数据扩充方法是通过对原始视频帧进行旋转、平移、缩放等几何变换来生成新的训练样本。此外,还可以采用颜色抖动、亮度调整等方法来模拟光照变化对目标的影响。更高级的数据扩充技术还包括利用生成对抗网络(GAN)等生成新的合成视频帧,以进一步增加模型的训练数据多样性。通过合理的数据扩充策略,可以有效提升运动目标识别追踪系统的性能和鲁棒性。

3.2 实验环境搭建

实验环境使用Windows操作系统,并利用Python作为主要的编程语言进行算法和模型的实现。使用PyTorch作为深度学习框架,构建和训练神经网络模型。借助Pandas等库,完成数据的加载、处理和转换。这样的实验环境提供了一个方便和高效的平台,用于开发和测试基于深度学习的运动目标识别追踪系统。

3.3 实验及结果分析

判断目标检测结果的好坏主要依据fps、mAP和IOU的数值。其中,fps表示每秒处理图像的数量,数值越大表示检测速度越快,检测效果越好。mAP(Mean Average Precision)表示平均精度,数值越大表示检测精度越高,检测效果越好。mAP综合考虑了准确率和召回率,通过计算正例和反例的判定情况来评估检测算法的性能。IOU(Intersection over Union)表示预测框与原标注框之间的重叠比值,数值越大表示预测框与真实框的匹配程度越好。综合考虑fps、mAP和IOU的数值可以全面评估目标检测算法的速度、准确性和匹配度,从而判断检测效果的好坏。

相关代码示例:

def change_image_partition_size(image, partition_size):

# 将图像划分为指定尺寸的块

partitions = [image[i:i + partition_size, j:j + partition_size] for i in range(0, image.shape[0], partition_size) for j in range(0, image.shape[1], partition_size)]

return partitions

# 数据筛选函数

def data_screening(partitions):

filtered_partitions = [part for part in partitions if partpassed_some_condition(part)]

return filtered_partitions

# k-means 聚类函数

def kmeans_clustering(filtered_partitions, num_clusters):

kmeans = KMeans(n_clusters=num_clusters)

kmeans.fit(filtered_partitions)

return kmeans实现效果图样例:

创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

最后

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)